Geschäftsführer, Abteilungs- und Teamleiter wollen einen permanenten Überblick über die Leistung der ihnen anvertrauten Unternehmenseinheit haben. Das gilt sowohl für klassische Beratungsteams in einem Beratungsunternehmen als auch zum Beispiel für Vertriebsteams in anderen Branchen. Das wird heute eigentlich auch meistens gemacht, die Umsetzung ist aber oft noch weit von einer praktikablen Lösung entfernt:

- Man nutzt die Reports, die die operativen Systeme wie Zeiterfassungssysteme, CRM, etc. heute anbieten.

- Man macht manuelle Datenexporte aus solchen Tools und verarbeitet sie dann in riesigen Excel-Tabellen.

- Man führt eigene CSV-Dateien, die die funktionalen Lücken „zwischen“ den bestehenden operativen Systemen schließen sollen und einige Sichten aus den betroffenen Systemen zeigen.

Herausforderung der Kunden

In der Praxis führt dies dazu, dass Manager verschiedener Ebenen Daten manuell aus 3-5 Systemen ziehen, in Excel-Dateien zusammenführen und diese dann manuell immer wieder harmonisieren müssen. Das Problem dabei ist, dass diese Routine 1-2 Wochen Aufwand pro Monat bedeuten kann, immer wieder zu Copy-Paste- und Formatierungsfehlern führt und die Ergebnisse nicht konsistent und nachhaltig sind. Dies wiederum führt zu Frustration und abnehmendem Vertrauen in die resultierenden Daten und KPIs.

Lösungsweg

Die Lösung liegt auf der Hand: Automatisierung des Prozesses. Eigentlich weiß das jeder, aber nicht jeder packt diese Aufgabe ernsthaft an. Die Gründe sind immer die gleichen:

- Man weiß nicht, wo man anfangen soll,

- Mangel an Ansprechpartnern und Experten für die Datenwelt,

- Furcht vor hohen Kosten.

Wir gehen das Thema pragmatisch an und beginnen in der Regel mit diesen vier Schritten:

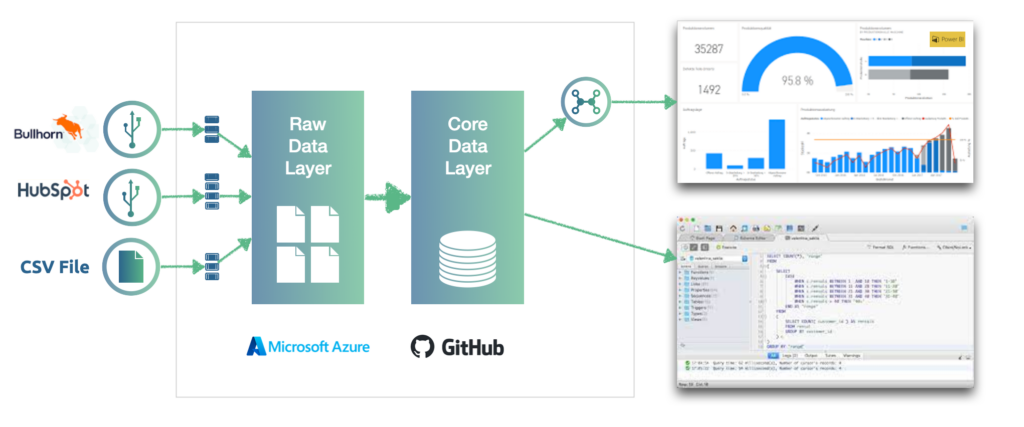

- Wir richten eine neue Cloud-Umgebung für den Kunden ein, in der Regel Microsoft Azure. Wenn eine vorhanden ist, setzen wir unsere Arbeit natürlich dort fort.

- Wir identifizieren, integrieren und konsolidieren (im ersten Schritt) die wichtigsten Daten für das Controlling-Team im neuen Cloud-basierten DWH.

- Auf Basis dieser Daten bauen wir ein einfaches Dashboard (z.B. mit Microsoft PowerBI) mit 3 Sichten auf die Daten. In der Regel handelt es sich um Leistungsinformationen pro Person, pro Team, pro Abteilung, und ein paar allgemeine Statistiken.

- Für Kunden, die über SQL-Grundkenntnisse verfügen, schaffen wir mit einem DB-Viewer die Möglichkeit, auf Basis des DWH weitere Reports und Sichten auf die Daten selbständig erstellen zu können.

Natürlich ist die Lösung leicht erweiterbar, sowohl für weitere Datenentitäten, die im DWH harmonisiert werden sollen. Auch die Entwicklung von komplexeren, aber auch sehr leistungsfähigen KI-basierten Lösungen – wie z.B. Verkaufsprognosen – ist problemlos möglich.

Grundsätzlich verfolgen wir in unseren Projekten die Self-Service-Philosophie. Wir versetzen unsere Kunden in die Lage, selbständig mit Daten zu arbeiten und weniger abhängig von anderen zu sein.

Laufzeit und Struktur der Projekte

In der Regel schließen wir ein solches Projekt innerhalb von 1,5-2 Monaten ab, mit 2-3 Wochen Vorlaufzeit. Üblicherweise besteht das Entwicklungsteam aus einem Data-Science-Experten (der auch für das Projekt verantwortlich ist) und einem / zwei Cloud-Architekten bzw. Data Engineers (verantwortlich für Architektur, Cloud, Datenmodellierung und Entwicklung).

Natürlich gehen wir im Projekt agil vor. Der Kunde hat immer die Kontrolle und kann die Prioritäten und den Umfang des Projekts jederzeit anpassen. Ein Sprint dauert bei uns in der Regel eine Woche. Nach jedem Sprint machen wir eine Demo und berichten über den Fortschritt und Aufwände.

Kosten

Die Kosten kann man nicht pauschal nennen. Jedoch je nach den Wünschen für die Gestaltung des Dashboards, der Anzahl der anzubindenden Datenquellen sowie der Anzahl der zu harmonisierenden Entitäten („Kunde„, „Projekt„, „Mitarbeiter„, „Buchungszeit„, etc.) im DWH, muss man mit Kosten von 25.000 – 35.000 Euro rechnen.

Aber wir gehen noch einen Schritt weiter: Auf Wunsch bauen wir solche Lösungen für den Kunden kostenneutral, profitieren dann in Form einer Vergütung von 30% der eingesparten Kosten / des zusätzlich erzielten Umsatzes innerhalb der nächsten 3 Jahre nach Projektabschluss.

Die Frage der Datenqualität wird in der Regel gesondert betrachtet.

Zusammenfassung

Die Welt der Daten kann beliebig kompliziert werden, aber sie bietet ein enormes Potenzial zur Risikominimierung, Kostensenkung und Ertragssteigerung. Das Wichtigste ist – einfach anfangen!

Wir streben ein Umdenken bei unseren Kunden an. Wir sehen unsere Zusammenarbeit als eine Investition in die Datenkompetenz ihres Unternehmens und nicht nur als eine Delegation von einmaligen Aufgaben an uns.

Haben Sie Fragen oder Anmerkungen zu diesem Case? Oder haben Sie andere Erfahrungen gemacht und möchten diese mit uns teilen? Dann kontaktieren Sie uns oder besuchen Sie auf unserer Webseite – www.qurix.tech.

Technologien

Microsoft Azure, Microsoft Power BI / Superset / Qlik, Azure Data Factory / Databricks, GitHub, Python & SQL

Image by Freepik